Transformatie van realtime datastromen

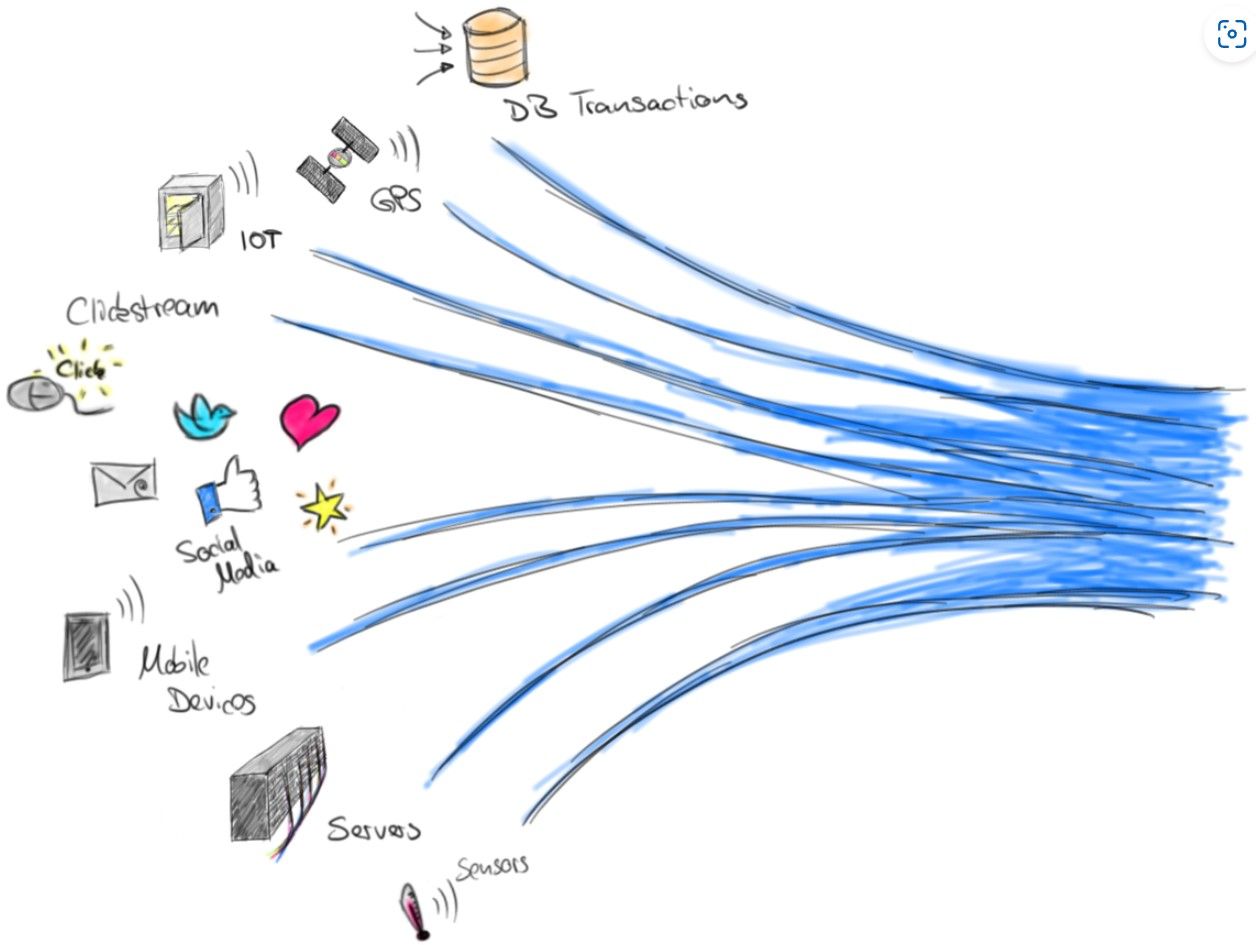

In de huidige digitale economie, waar data de nieuwe olie is, wordt de behoefte aan realtime datastreaming en -distributie steeds belangrijker. Bedrijven in sectoren van financiën tot retail en van IoT tot sociale media, allen vertrouwen ze op de onmiddellijke verwerking van data om inzichten te verkrijgen, beslissingen te nemen, en gebruikerservaringen te verbeteren. Hier speelt Apache Kafka een cruciale rol.

Maar wat maakt Kafka zo uniek en waardevol voor het beheren van realtime datastromen? In deze blog verkennen we dit verder.

Waarom is Kafka zo effectief?

Schaalbaarheid

Eén van de meest prominente voordelen van Kafka is zijn ongeëvenaarde schaalbaarheid. Het kan zonder problemen petabytes aan data verwerken, dankzij zijn vermogen om horizontaal over meerdere servers (of brokers) te schalen. Dit maakt het mogelijk om met de groei van data en verkeer mee te schalen, zonder in te boeten aan prestaties of betrouwbaarheid.

Betrouwbaarheid

Kafka is ontworpen met fouttolerantie in gedachten. Het kan replicaties van data over verschillende nodes ondersteunen, wat zorgt voor een hoge beschikbaarheid en duurzaamheid van data, zelfs in het geval van systeemfalen. Dit is cruciaal voor bedrijven die afhankelijk zijn van continue datastroom zonder onderbrekingen.

Lage latency

Voor realtime data processing is snelheid essentieel. Kafka biedt lage latency bij het verwerken van datastromen, wat betekent dat data bijna onmiddellijk beschikbaar is voor analyse en actie. Dit is bijzonder waardevol in scenario's zoals fraudedetectie, waar elke seconde telt.

Hoe werkt dit technisch ?

Topics, partities en replicatie

Een diepere duik in Kafka's architectuur onthult hoe het zijn robuustheid en prestaties bereikt, essentieel voor het verwerken van realtime data. Het hart van Kafka's dataopslagmechanisme is de 'topic', een categorie of feednaam waarnaar records worden gepubliceerd. Topics zijn verdeeld in 'partities', die op hun beurt over verschillende 'brokers' binnen een Kafka-cluster kunnen worden verdeeld. Dit ontwerp maakt parallelle dataconsumptie mogelijk, waardoor Kafka hoge doorvoer kan bereiken. Cruciaal is dat elke partitie geordende, onveranderlijke records behoudt, en dat records alleen aan het einde worden toegevoegd, wat een fundamentele eigenschap is die de betrouwbaarheid van datastreams garandeert.

Replicatie is een ander kernaspect van Kafka's technische infrastructuur, wat de duurzaamheid en fouttolerantie van het systeem aanzienlijk verbetert. Elke partitie kan over meerdere brokers worden gerepliceerd, waarbij elke kopie van een partitie op een andere broker leeft. Dit betekent dat als een broker faalt, Kafka automatisch overschakelt naar een replica, zonder dataverlies of onderbreking. Dit replicatiemechanisme is essentieel voor missiekritieke toepassingen waar dataverlies onaanvaardbaar is.

Realtime analyse en verwerking

Voorbij de basisfunctionaliteit van dataopslag en -distributie, biedt Kafka ook mogelijkheden voor stream processing via Kafka Streams en KSQL. Kafka Streams is een clientbibliotheek voor het bouwen van applicaties en microservices, waar de input en output data worden opgeslagen in Kafka topics. Het stelt ontwikkelaars in staat om complexe data processing operaties te implementeren, zoals het filteren van streams, het samenvoegen van meerdere streams, en het uitvoeren van aggregaties en joins in realtime. Dit maakt Kafka niet alleen een platform voor data transport, maar ook een krachtig hulpmiddel voor data transformatie en verrijking.

KSQL, een SQL-achtige interface voor stream processing, biedt een meer toegankelijke manier om datastromen te verwerken en te analyseren. Met KSQL kunnen gebruikers complexe queries schrijven op streamende data in Kafka, vergelijkbaar met traditionele databases, maar met het voordeel van realtime verwerking. Dit opent de deur voor realtime analytics, monitoring, en event-driven applicaties, allemaal binnen het Kafka-ecosysteem.

Casestudies: Kafka in actie

Financiële diensten

In de wereld van financiën wordt Kafka gebruikt voor het monitoren van transacties in realtime, waardoor frauduleuze activiteiten snel gedetecteerd en voorkomen kunnen worden. Banken en financiële instellingen gebruiken Kafka ook voor real-time betalingsverwerking en om te voldoen aan regelgeving door transacties nauwkeurig te loggen en te archiveren.

E-commerce

Grote e-commerce platforms gebruiken Kafka om gebruikersinteracties te volgen, zoals paginabezoeken, zoekopdrachten en aankopen. Deze data wordt gebruikt voor realtime analyse om gepersonaliseerde aanbevelingen te genereren, de voorraad te beheren, en de gebruikerservaring te optimaliseren.

IoT

In de IoT-sector wordt Kafka ingezet om data van miljoenen apparaten te verzamelen en te verwerken. Dit stelt bedrijven in staat om in realtime inzicht te krijgen in apparaatprestaties, onderhoudsbehoeften te voorspellen en nieuwe gebruiksscenario's te ontwikkelen.

Uitdagingen en best practices

Hoewel Kafka krachtig is, komt het met zijn eigen set uitdagingen, zoals complexiteit in setup en beheer, en de noodzaak van zorgvuldige planning rond data schema's en netwerkarchitectuur. Best practices omvatten het gebruik van schema-registry voor data consistentie, het monitoren van cluster performance, en het implementeren van beveiligingsmaatregelen zoals encryptie en authenticatie.

Most.dev heeft bij verscheidene organisaties Kafka geïmplementeerd. Hierbij hebben we verschillende combinaties toegevoegd. Wij kunnen ook jouw organisatie hierbij helpen.